前言:我和提示词的爱恨情仇

![图片[1]-从“提示词炼金术”到“上下文工程学” 一个被大模型折磨过的程序员的血泪史-AI Spot](https://www.aispot.com.cn/wp-content/uploads/2025/10/1760967413-a0b00f07ce2078e8e0191a1b4dd9c380.png)

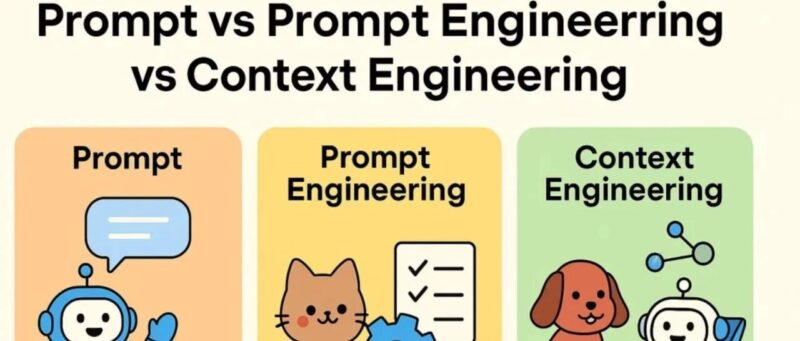

曾几何时,我以为自己是”提示词大师”。那时候我会花三个小时调一个prompt,像古代炼金术士一样,在各种神秘符号和咒语中寻找黄金配方。”请你扮演一个资深的、经验丰富的、具有十年以上工作经验的…”——我的提示词开头总是这么冗长,仿佛字数越多,模型就越聪明。

然后现实给了我一巴掌。同样的提示词,今天给我写出莎士比亚,明天给我写出小学生作文。我开始怀疑人生,也开始怀疑这些AI是不是也有”星期一综合症”。

直到我发现了”上下文工程“这个概念,才意识到:我一直在用魔法的方式解决工程问题。这就像用占卜来调试代码一样——偶尔灵验,但绝对不可持续。

![图片[2]-从“提示词炼金术”到“上下文工程学” 一个被大模型折磨过的程序员的血泪史-AI Spot](https://www.aispot.com.cn/wp-content/uploads/2025/10/1760967415-7a18b8b40fdd0ee69a2e71b0873e41d0.png)

![图片[3]-从“提示词炼金术”到“上下文工程学” 一个被大模型折磨过的程序员的血泪史-AI Spot](https://www.aispot.com.cn/wp-content/uploads/2025/10/1760967415-7a18b8b40fdd0ee69a2e71b0873e41d0.png)

一:为什么我们需要上下文工程(除了拯救程序员的头发)

让我先问你一个问题:你会雇一个每天心情不同、今天是莎士比亚明天是话痨的员工吗?当然不会。但我们却一直在容忍AI的这种”艺术家脾气”。

上下文工程的核心思想很简单:把AI当作一个需要详细工作说明书的新员工,而不是一个需要灵感启发的艺术家。这意味着:

稳定性:不再靠人品出活。同样的输入,稳定的输出。就像你的代码一样——至少应该像你的代码一样。

可控性:设定边界,避免AI”热心过度”。我们都见过那种新员工,你让他写个邮件,他能给你写成诗歌朗诵会邀请函。

可评测性:有了明确标准,才能做A/B测试。不然就是在比较”今天的月亮”和”昨天的太阳”。

经济性:用更少的token做更多的事。毕竟,每次调用API都在烧钱,而程序员的工资已经够贵了。

二:上下文工程的八大要素(比八卦更有用)

想象你要给一个外星人解释如何在地球上点外卖。你需要告诉他:

- 角色设定:你是一个饿了的地球人(不是要征服地球的外星人)

- 目标明确:获得食物,而不是研究人类饮食习惯

- 输入材料:手机、APP、钱包、地址

- 规则约束:不要点超出预算的,不要点需要等三小时的

- 示例参考:这样点是对的,那样点会饿死

- 工具使用:如何操作APP,如何付款

- 输出格式:最终你会收到食物,不是收到哲学思考

- 自检清单:确认地址、确认支付、确认不是点了猫粮

这就是上下文工程的八要素。听起来复杂,但比教外星人点外卖简单多了。

第三章:从”佛系提示”到”工程化上下文”的华丽转身

让我用一个真实案例来说明差别。我们需要AI写客户道歉邮件:

佛系提示时代(我的黑历史):

请帮我写一封道歉邮件,因为我们延期交付了。要诚恳一点。结果:有时候AI写得像在忏悔,有时候像在写遗书,有时候直接承认了所有法律责任。我们的法务同事看了想打人。

工程化上下文时代(我的救赎):

角色:你是B2B客户成功经理,目标是在延期情况下维持客户关系,避免流失。输入:客户名称、合同信息、延期原因、新交付时间、补偿方案约束:- 语气:专业、诚恳、负责任,但不过度情绪化- 法律:不承认法律责任,不透露内部机密- 结构:问候→情况说明→责任承担→解决方案→时间表→联系方式正面示例:[一封恰到好处的道歉邮件]反面示例:[一封"诚恳过头差点赔钱"的邮件,标注问题所在]输出格式:标题、正文、变量清单(方便CRM系统使用)自检清单:✓ 是否提供了明确的新时间表?✓ 是否有具体的改进措施?✓ 是否避免了法律风险?✓ 是否保持了专业语气?

结果:稳定、可控、法务同事不再想打人。这就是工程的力量。

四:RAG——让AI不再”一本正经地胡说八道”

RAG(检索增强生成)听起来很高大上,其实就是给AI配个图书管理员。以前AI回答问题全靠”记忆”(其实是训练数据),现在可以现查现用。

但是,给AI配图书管理员也有讲究:

文档切分:不能把整本百科全书扔给AI,要按章节、段落合理切分。就像你不会把整个代码库发给新同事说”自己看着办”。

召回策略:用向量搜索+关键词搜索的组合拳,确保找到最相关的信息。单纯的向量搜索有时候会找到”语义相似但内容无关”的段落,就像搜”苹果手机”结果给你”苹果派食谱”。

强制引用:这是重点!每个重要结论后面都要标注来源。没有引用的AI回答就像没有注释的代码——看起来很厉害,但没人敢用。

我们的做法是在每个答案后面加上 [文档ID-段落号 ] ,让用户可以追溯到原始信息。证据不足时,AI会老实说”我不确定,建议咨询相关专家”,而不是编一个听起来很有道理的答案。

五:评测——不要让“感觉良好”欺骗你

程序员都知道,没有测试的代码就像没有刹车的汽车。上下文工程也一样,需要严格的评测体系。

评测集设计:准备10-30个测试用例,覆盖:

- 正常情况:AI应该能轻松处理的

- 边界情况:信息不全、模糊问题、多重含义

- 对抗样例:故意诱导AI犯错的输入

自动化评估:

- 格式检查:输出是否符合预期结构

- 引用验证:声明是否有对应的证据支持

- 规则遵守:是否违反了约束条件

人工抽检:机器评估再准确,也需要人类的最终把关。特别是涉及法律、医疗、金融等高风险领域。

线上监控:部署后持续监控关键指标:

- 帮助率:用户问题得到满意解答的比例

- 拒答率:AI主动说“不知道”的比例(这个指标很重要!)

- 平均响应时间和成本

- 用户满意度反馈

六:常见坑点(我踩过的那些雷)

坑1:指令堆积症

症状:觉得指令越详细越好,恨不得写成论文

现实:信息过载,重点被淹没

治疗:删减是第一生产力,保留核心要素即可

坑2:示例选择困难症

症状:给了很多示例,但风格不一致

现实:AI学会了”多重人格”

治疗:精选1-3个一致性强的正例,加1个标注清楚的反例

坑3:完美主义晚期

症状:想要AI处理所有边界情况

现实:系统复杂度爆炸,维护成本飙升

治疗:先解决80%的常见问题,剩下20%交给人工

坑4:工具调用恐惧症

症状:害怕AI调用外部工具出错

现实:限制了AI的能力发挥

治疗:设计好工具签名和错误处理,让AI”有权限犯错”

七:一周上手指南(比学会使用咖啡机更简单)

第1天:选择一个高频场景,写出”一页纸需求”

- 这个AI要解决什么问题?

- 成功的标准是什么?

- 失败的后果有多严重?

第2-3天:设计八要素模板

- 角色、目标、输入、约束、示例、工具、输出、自检

- 准备10-20个测试用例

第4天:如果需要RAG,搭建最简版本

- 文档切分和向量化

- 简单的召回和重排

- 强制引用机制

第5天:加入错误处理和降级策略

- 证据不足时怎么办?

- 工具调用失败时怎么办?

- 如何优雅地转人工?

第6-7天:测试、监控、迭代

- 跑完所有测试用例

- 设置基本监控

- 记录问题和改进点

八:我的一些偏执观点(通常很有用)

版本控制强迫症:把每个上下文模板都当作代码来管理,有版本号、变更日志、回滚策略。相信我,当你的AI突然”性格大变”时,你会感谢这个习惯。

小模型优先主义:不要一上来就用最大最贵的模型。往往一个设计良好的上下文+中等模型,效果比粗糙上下文+顶级模型更好,成本还低得多。

三层分离洁癖:系统指令、用户输入、外部证据要分开注入,不要混在一起。这样出问题时容易定位,就像代码的模块化一样。

结构化输出强迫症:哪怕是写邮件,也要给出结构化的输出(标题、正文、变量清单)。机器好处理,人类也好修改。

安全第一原则:把合规检查做成独立的”守门员”,不要和创作指令混在一起。安全问题不是创意问题。

从炼金术士到工程师的转变

回想起来,我从”提示词炼金术士”转变为”上下文工程师”的过程,就像从占卜师转行做程序员一样——少了些神秘感,多了些可预测性。

是的,工程化的方法可能没有那么”酷”,没有”一个神奇提示词解决所有问题”的浪漫。但它有更重要的东西:可靠性、可维护性、可扩展性。

就像我们写代码一样,最酷的不是那些炫技的一行代码,而是那些运行了三年从未出错的系统。

所以,放下你的炼金术士帽子,拿起工程师的键盘吧。让我们一起把AI从”偶尔灵验的占卜师”训练成”稳定可靠的同事”。

毕竟,在这个AI时代,我们程序员的价值不在于会写神奇的提示词,而在于能够设计出稳定、可控、可维护的AI系统。

这才是真正的魔法。

暂无评论内容