这是「海外播客来信 第 81 期」,我们每天为你更新硅谷最新的 AI 创业与产品播客总结,让你与前沿保持同频。全文约 8100 字,已转成播客方便收听 ↓

“伟大的 AI 公司,不只是技术突破,而是价值观的选择。”

“每一个模型决策,都是一次伦理判断。”

“创业的速度必须与责任感匹配。”

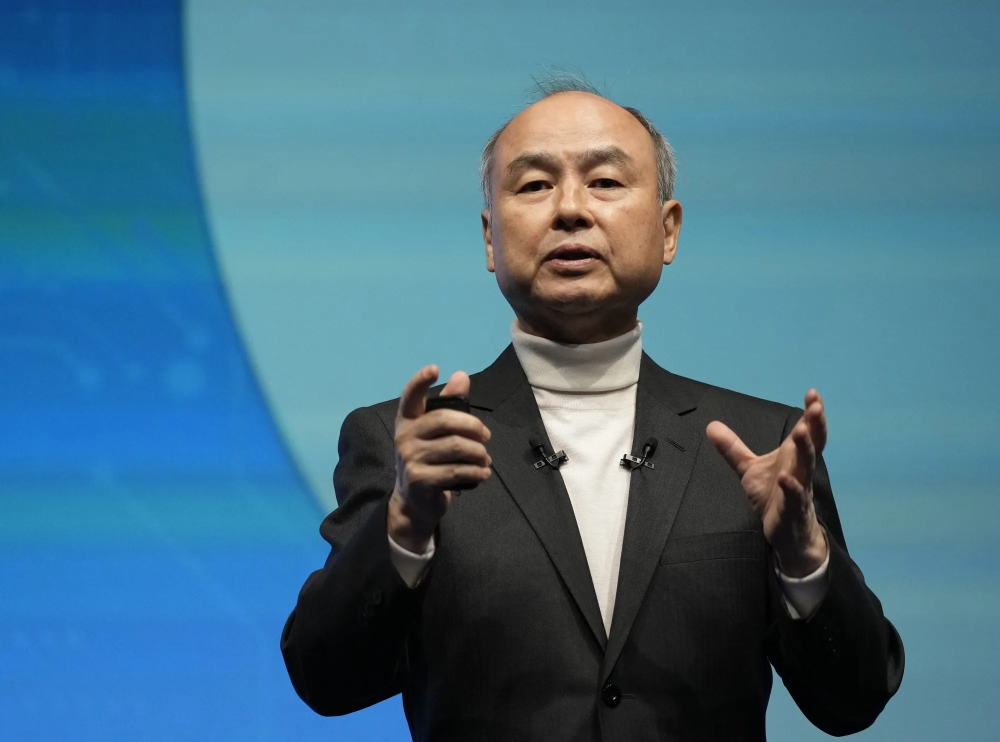

Jordan Fisher 是 Anthropic 的研究负责人,曾在 OpenAI 与 DeepMind 从事安全与模型评估工作,也是一位连续创业者、Y Combinator 校友。他在 Y Combinator Podcast 中提出:当 AI 进入可商用规模后,创始人需要重新思考十个根本问题——这些问题不在产品层面,而在战略与伦理层面。以下为核心内容整理。

1. 你的公司是在“构建智能”,还是在“租用智能”?

Jordan 指出,当前 AI 创业最大的盲点是:太多公司仅仅在“调用”模型,而不是“构建”自己的智能能力。 “真正的差异化,不在模型参数,而在学习回路。” 只有当团队能在数据、反馈和用户交互上形成闭环,智能才属于你自己。

他举例,一家教育 AI 初创公司通过积累学生答题数据训练专属模型,最终教学质量超越同类。

“租来的智能让你快,养成的智能让你长。” —— Jordan Fisher

AI 创业的根本是拥有自己的反馈循环。

2. 你的核心资源:算力、数据,还是信任?

“在 AI 时代,最稀缺的不是算法,而是信任。” Jordan 强调。 数据可被复制,算力可被租用,只有信任无法外包。 他建议创始人早期就确立价值边界:如何处理用户隐私、如何解释模型决策。 “用户不会因为你聪明而留下,只会因为你可信而长期使用。”

Anthropic 内部有一条准则:所有功能上线前必须回答 3 个问题—— ① 我们是否愿意公开解释它的行为? ② 用户是否能理解决策来源? ③ 最坏情况下是否仍符合社会预期?

AI 产品的核心壁垒是可解释性带来的信任,而非闭源。

3. 你是否在构建“防御力”,而不仅仅是速度?

Jordan 提醒 YC 创始人:当前的 AI 竞赛容易让团队陷入“发布焦虑”,忽视防御力。 “在模型层面,防御力是反馈数据;在组织层面,防御力是文化。”

他列举了两类失败: – 技术领先但无反馈系统(用户流失); – 产品成功但文化崩塌(伦理丑闻)。 “速度是一种策略,防御是一种结构。” 真正优秀的公司在冲刺中仍保留审查机制。

“没有防御力的速度,只是自我消耗。” —— Jordan Fisher

4. 谁在为你的模型决策负责?

AI 系统的决策责任问题正在成为伦理核心。Jordan 提出: “每一个 AI 输出,背后都隐含一个人的判断。” 创始人必须明确责任链:谁能改模型、谁能审核、谁对偏差负责。

他分享 Anthropic 的做法: – 建立内部“责任日志”; – 要求每个模型变更都记录“影响假设”; – 设置伦理 review 与外部顾问。 这些流程听似繁琐,却让团队在快速迭代中保持警觉。

透明不是约束,而是加速学习的手段。

5. 你在训练模型,还是在训练人?

Jordan 说:“我们常说模型会学习,但忽视了人也在被训练。” 创始人必须意识到:产品的交互逻辑会塑造用户行为。 例如,当语言模型不断强调“快速答案”,用户会逐渐失去提问耐心。

他提醒: “你不仅设计 UX,还在设计思维习惯。” AI 创业者应思考如何让系统帮助人更好地思考,而不是只追求效率。

“好的 AI 让人更像人,坏的 AI 让人更像机器。” —— Jordan Fisher

6. 如果模型出错,你是否能解释原因?

可解释性是 AI 安全的前提。Jordan 指出,大部分团队在模型出错时只做热修复,而非系统分析。 他建议建立“事后可追溯机制”:记录输入、版本、上下文,复现路径。 “我们在 Anthropic 的原则是:任何输出都要能解释到责任人和训练数据。”

他提醒创业者:可解释性不仅是合规要求,更是信任机制。 “当错误可被追踪时,用户就不会恐惧。”

“不透明的系统,无法建立长期品牌。” —— Jordan Fisher

7. 你的增长假设是否可持续?

Jordan 指出,很多 AI 公司早期增长惊人,但长期留存极差。 原因在于他们的增长来自“技术新鲜感”,而非持续价值。 他提醒创始人从一开始就问: – 当新模型出现,我的用户为什么不离开? – 我的数据飞轮能否自我强化?

“真正的护城河,是不断积累的真实使用数据。” 而不是短期媒体热度。

他举 Grammarly 的例子:公司十年如一日地积累写作行为数据,使模型越用越准。 “增长是副产品,不是目标。”

“AI 公司不怕慢,只怕空转。” —— Jordan Fisher

8. 你如何平衡开放与防护?

AI 安全与开放之间的矛盾,是所有创始人必须面对的现实。 Jordan 认为,完全开源与完全封闭都不可持续。 “最健康的状态,是可控透明。”

他举 Anthropic 的例子:公司采用“可审计开放”,允许研究者访问模型,但隐藏关键安全层。 这种中间状态既保证创新,又防止滥用。 他建议初创公司在早期就建立数据审计接口,为未来合规留空间。

“开放不是放弃控制,而是邀请监督。” —— Jordan Fisher

9. 你的团队是否具备跨学科视角?

AI 创业不是纯技术问题。Jordan 强调,未来最强的团队一定是跨学科的——既懂 ML ,也懂 psychology、ethics 与 design。 “AI 公司的核心竞争力,不是代码量,而是理解人的能力。”

他建议创始人引入哲学家、社会学家、政策顾问进入早期顾问组,让决策更全面。 “人文科学是 AI 时代的新工程学。”

“如果团队里没有不同声音,你的模型注定会单一。” —— Jordan Fisher

10. 你是否准备好成为“社会基础设施”?

Jordan 最后提出最重要的问题:“当你的 AI 被数百万人使用时,它已不只是产品,而是社会基础设施。” 创始人必须重新定义自己的责任: —— 模型输出会影响教育、就业、舆论; —— 错误信息可能被放大; —— 算法偏见会改变社会分配。

“当 AI 触达社会底层,它就不再是中性工具。” 他呼吁创业者以“公共服务心态”设计系统,而非仅仅追求利润。

“技术的力量越大,伦理的边界越近。” —— Jordan Fisher

结语

Jordan Fisher 的十个问题,像是一份 AI 创业者的哲学考卷。 它提醒我们:AI 不再是“快者为王”的战场,而是一场关于责任、透明与信任的长期竞赛。

对于创始人来说,这十问可归结为三句话:

✅ 想清楚为什么而造,而不是能不能造。

✅ 让智能服务人性,而不是替代人性。

✅ 速度要匹配责任,创新要匹配解释。

正如 Jordan 所说: “AI 创业的终极挑战,不是技术壁垒,而是人类自我理解的深度。”

AI 的未来,属于那些能回答‘为什么’的人。

内容来源:“Every AI Founder Should Be Asking These Questions” 丨 Y Combinator Podcast(嘉宾:Jordan Fisher,Anthropic 研究负责人 & AI 创业者)

相关文章

⇣ 关注我,每天为你更新硅谷最新的 AI 创业/产品播客总结,让你与硅谷同频 ⇣

<

暂无评论内容